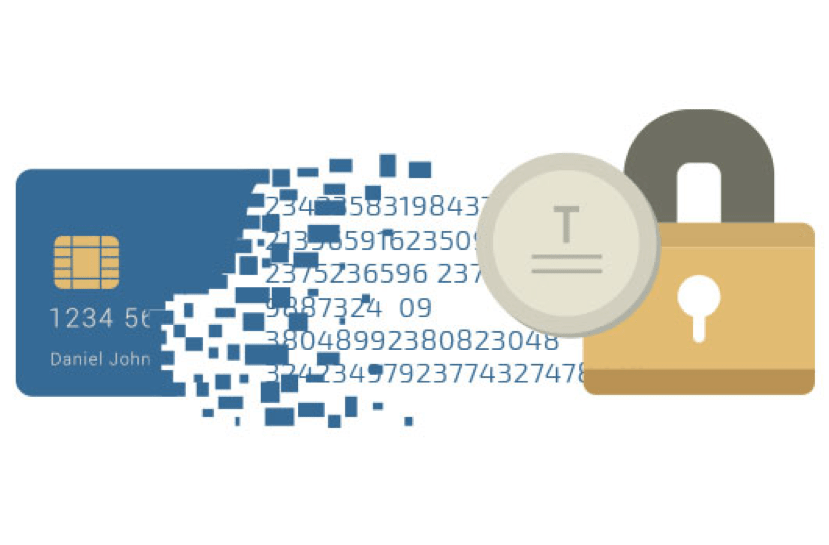

Es cuando se aplica seguridad en los datos, es el proceso de sustitución de un elemento de datos sensible por un equivalente no sensible, denominado token, que no tiene un significado o valor extrínseco o explotable. El token es una referencia (es decir, un identificador) que regresa a los datos sensibles a través de un sistema de tokenización. El mapeo de datos originales a un token utiliza métodos que hacen que los tokens no sean factibles de revertir en ausencia del sistema de tokenización, por ejemplo, utilizando tokens creados a partir de números aleatorios. El sistema de tokenización debe ser asegurado y validado utilizando las mejores prácticas de seguridad aplicables a la protección de datos confidenciales, el almacenamiento seguro, la auditoría, la autenticación y la autorización. El sistema de tokenización proporciona a las aplicaciones de procesamiento de datos la autoridad y las interfaces para solicitar tokens o destokenizar datos sensibles.